AI pod lupou: bezpečnostní rizika

Využíváte populární nástroje, jako jsou ChatGPT a Midjourney? Přemýšlíte nad tím, jakou stopu v nich zanecháváte? Víme, že AI nástroje jsou skvělé, ale pojďme se podívat na bezpečnostní aspekty a ochranu soukromí, které občas necháváme na okraji zájmu.

Porozumění bezpečnostním výzvám nástrojů umělé inteligence je důležité pro každého z nás, a právě proto se tomuto tématu věnoval Tomáš Doležal ve svém webináři AI pod lupou: Bezpečnostní rizika. A o čem byla řeč?

Soukromí a zabezpečení AI nástrojů

Společnost OpenAI se nijak netají tím, že kdokoliv z jejího týmu si může prohlížet vaši komunikaci s ChatemGPT, a zároveň tato data používat k dalšímu tréninku systému. OpenAI také vyzývá, abyste s chatbotem nesdíleli žádné citlivé informace. Jak shrnul Tomáš – v podstatě vše, co zadáte do ChatuGPT, je veřejná informace. Stejně tak platforma Midjourney, která využívá veřejné servery na Discordu pro komunikaci, nezajišťuje úplné soukromí. Při použití těchto nástrojů by proto mělo být na prvním místě zodpovědné zacházení s vlastními daty. Jakékoli informace, které poskytneme, mohou být totiž přístupné jiným stranám. Myslete na to, až budete vytvářet další konverzace.

AI pomáhá i „temné straně“ a lže

Umělá inteligence je skvělý pomocník, ale využívají toho bohužel také dezinformátoři, phisheři a další škodiči. ChatGPT dokáže vytvářet věrohodné texty, umí generovat kódy; Midjourney umožňuje realisticky znázornit události, které se nestaly – zkrátka stačí správné instrukce a AI poslouží jakémukoliv účelu.

Nebezpečným fenoménem jsou však také tzv. halucinace, tedy případy, kdy AI, konkrétně ChatGPT, podává velice přesvědčivě nepravdivé informace, což může vést k řadě nedorozumění.

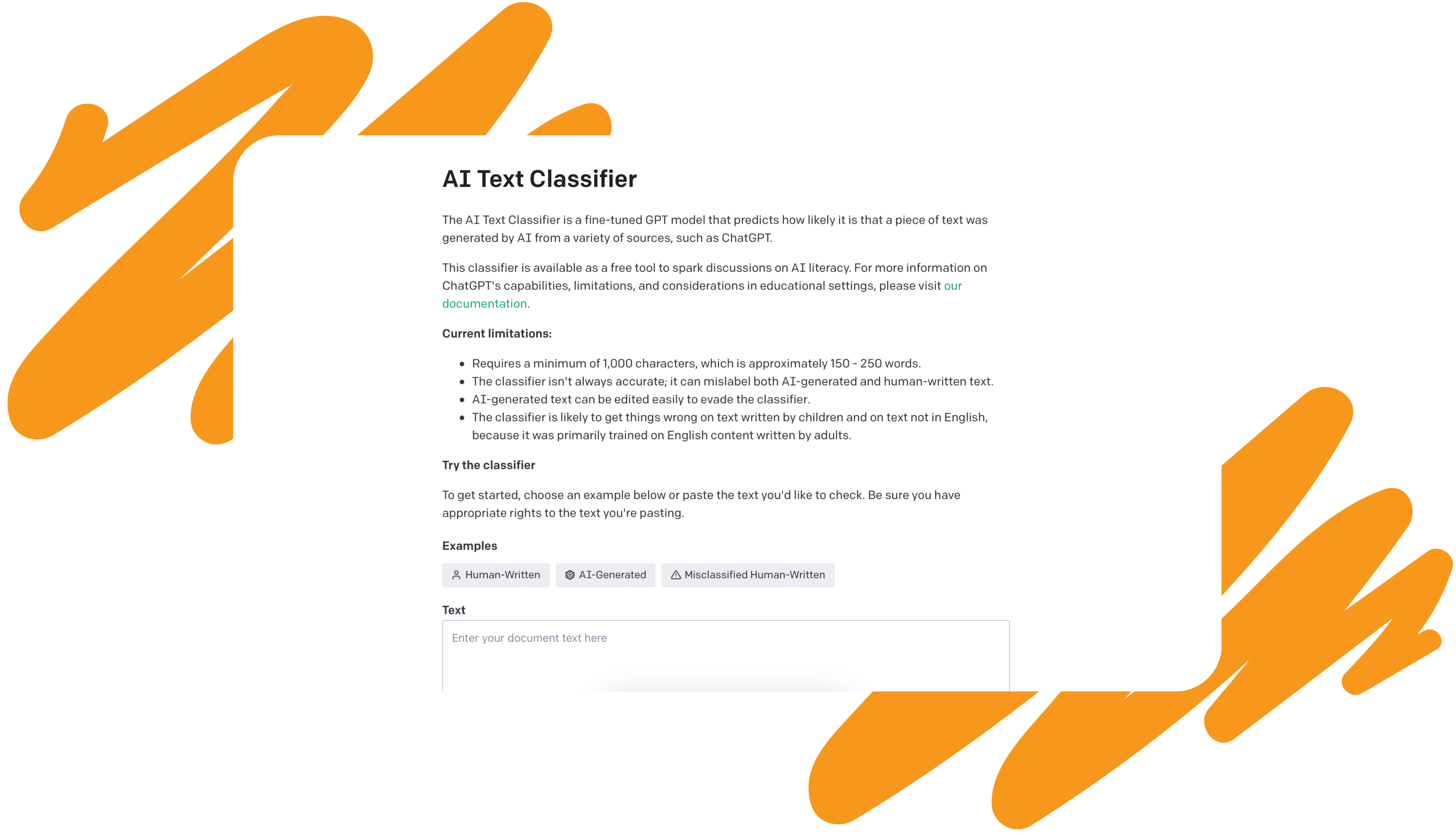

Nicméně AI současně pomáhá bojovat proti hrozbám, na kterých se nevědomky podílí, a je schopná zpětně identifikovat takzvané deepfaky i škodlivé kódy. OpenAI také poskytuje nástroj, který dokáže ověřit, zda byl text vygenerován pomocí ChatuGPT. Nutno také připomenout, že veškeré informace, které AI „vyplivne“, musíme brát s rezervou a ověřovat.

Přístupy k AI

Věděli jste, že obavy z nakládání s daty uživatelů vedly k úplnému zákazu ChatuGPT v Itálii? Čína se pro změnu pustila do vývoje vlastních systémů. A třeba Česká spořitelna se stala první evropskou bankou využívající chatbot postavený na GPT-3.5. Možná jste také zaznamenali, že AI je velké téma pro vzdělávací instituce – některé mají obavy, zatímco například Masarykova univerzita vidí v AI příležitost a podporuje její efektivní využití mezi studenty a pedagogy. Všechny tyto příklady nám ukazují, jak výrazný dopad má umělá inteligence na naši společnost a jak je důležité hledat správný způsob, jak s ní naložit. AI je tady a týká se zkrátka všech.

Co s tím?

Přistupujte k nástrojům AI zodpovědně – zkoumejte, zkoušejte, ale ověřujte a myslete na to, že data, která vkládáte, jsou veřejná – minimálně pro společnosti, jež tyto nástroje provozují.

Pár rychlotipů, jak na AI bezpečně:

- Nezadávejte žádné citlivé informace.

- Důkladně ověřujte informace, které vám chatboti vracejí.

- Pracujte v private modech, pokud je nástroje nabízejí.

Co se bude dál?

Nástroje umělé inteligence se neustále vyvíjejí a rozmáhají. A máme se na co těšit – hodně se očekává například od řešení Microsoftu Copilot 365 a zahálet nebudou ani další velcí hráči. Myslete ale v každém případě na to, že s měnícími se nástroji se musí měnit i náš přístup k ochraně soukromí a bezpečnému využití těchto technologií.